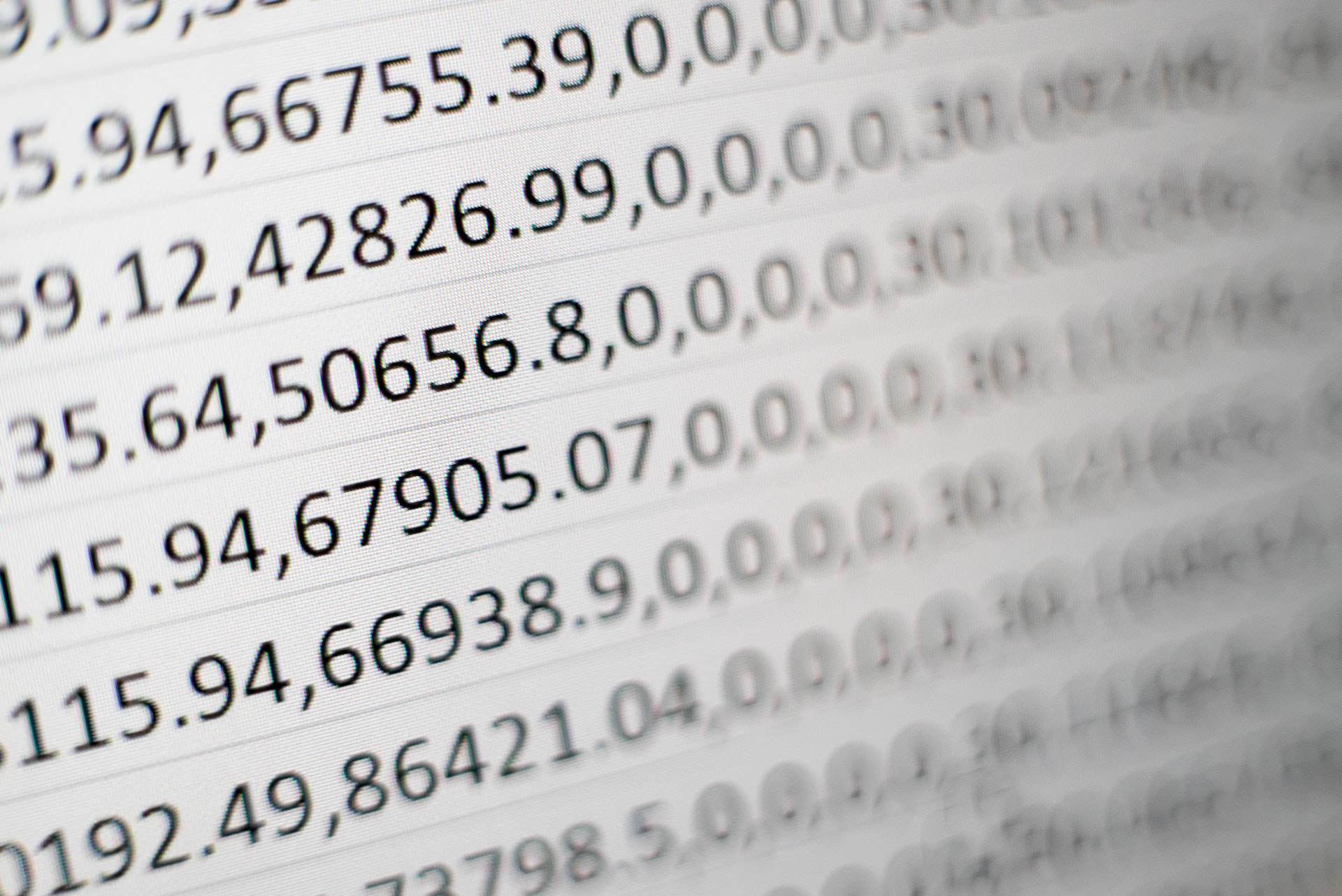

Depuis l’Antiquité, les statistiques ont été un pilier de la compréhension du monde qui nous entoure. De Pythagore à la science des données moderne, il y a un élément qui reste primordial : les paramètres. Les paramètres sont essentiels dans toute analyse statistique et peuvent faire ou défaire le succès d’une expérience. Dans cet article, nous explorerons l’importance des paramètres en statistiques, en découvrant pourquoi ils sont si essentiels pour des résultats précis.

Comme quelqu’un l’a dit un jour, « Un voyage de mille kilomètres commence par un seul pas« . Pour comprendre le rôle des paramètres en statistiques, il est utile de regarder d’abord ses fondements : comment la théorie statistique s’applique-t-elle ? Les statistiques consistent essentiellement à trouver des modèles et des relations entre les variables ; en traçant ces points sur un graphique, vous pouvez tirer des conclusions sur les tendances et les corrélations. Tout cela est rendu possible en combinant deux idées clés : la probabilité et l’inférence. La probabilité nous indique ce qui est susceptible de se produire dans certaines conditions, tandis que l’inférence nous permet de généraliser à partir de ces observations et de faire des prédictions.

Les paramètres jouent un rôle important à la fois dans les modèles probabilistes et les processus de raisonnement inférentiel – ils fournissent une structure à nos analyses en contrôlant la plage de valeurs utilisées pour calculer les probabilités et donner un sens. Avec une paramétrisation appropriée, vous pouvez obtenir des mesures plus précises qui donnent un aperçu des tendances sous-jacentes dans votre ensemble de données. Alors plongeons plus profondément dans ce que font exactement les paramètres lors de l’analyse des statistiques – leur impact sur les calculs ainsi que les implications sur la précision – afin que vous puissiez également débloquer la puissance des paramètres dans votre propre recherche !

Qu’est-ce que les paramètres ?

Il est presque ironique que lorsqu’il s’agit de comprendre les paramètres en statistiques, la première question à se poser soit « qu’est-ce que les paramètres ? ». Les paramètres ont été utilisés pour représenter les caractéristiques de la population et les mesurer depuis longtemps. En fait, ils sont devenus si essentiels aux statistiques inférentielles que leur importance ne peut être surestimée.

Les paramètres nous permettent de comparer des échantillons avec des populations en évaluant certaines caractéristiques de la taille de l’échantillon ou même de l’ensemble des données. Ils nous aident à déterminer si l’échantillon donné suit une distribution normale et à identifier sa tendance centrale en utilisant des mesures telles que la moyenne et la variance. Cela nous aide également à évaluer la quantité de variation entre des échantillons aléatoires prélevés dans la même population – quelque chose que nous appelons l’écart-type qui est généralement mesuré en prenant la racine carrée de la variance.

En résumé, les paramètres jouent un rôle important dans les statistiques inférentielles car ils fournissent un aperçu des caractéristiques de la population grâce à la comparaison de différents échantillons prélevés dans celle-ci. Sans eux, il serait impossible de faire des hypothèses valides sur nos ensembles de données et de tirer des conclusions précises sur la population sous-jacente.

Types de paramètres

Connaître les différents types de paramètres et comment ils sont utilisés peut être comme découvrir un trésor caché – cela ouvre un tout nouveau monde de compréhension et d’insight. En statistique, il existe deux types principaux de paramètres: les statistiques descriptives et les paramètres communs.

Les statistiques descriptives aident à résumer un ensemble de données en fournissant des caractéristiques numériques telles que la plage et la moyenne. Les paramètres communs proviennent de distributions de probabilité qui décrivent la probabilité de certains résultats se produisant dans l’erreur d’échantillonnage. Ils nous fournissent des informations sur les tendances futures en examinant les données passées. L’inférence statistique nous aide à tirer des conclusions sur les populations en fonction de ce que nous apprenons des ensembles de données d’échantillons.

La plage de valeurs associée à chaque type de paramètre est importante lors de l’analyse de données car elle nous donne une bonne idée de la variation existant au sein de la population d’échantillons ou entre différents échantillons. En examinant à la fois les statistiques descriptives et les paramètres communs, nous pouvons obtenir des informations précieuses sur nos ensembles de données afin de prendre des décisions éclairées à l’avenir.

Exemples de paramètres en statistiques

Certains pourraient argumenter que les exemples de paramètres en statistiques sont trop abstraits pour être compris. Au contraire, comprendre comment et pourquoi les paramètres existent est essentiel pour toute analyse statistique.

Des paramètres tels que la taille de la population servent de base à toutes les calculs statistiques. Par exemple, si vous voulez générer une estimation impartiale à partir d’un échantillon aléatoire, la taille de la population doit être connue afin qu’elle puisse influencer les distributions binomiales et la variance de l’échantillon. De même, lors de la détermination de l’erreur standard d’un échantillon représentatif, il est important de connaître des paramètres tels que la taille de la population. En étant capable d’identifier ces paramètres et leur but en statistiques, on peut acquérir des aperçus plus profonds sur la façon d’interpréter correctement les données.

En plus de cela, d’autres types de paramètres existent également qui se complètent mutuellement afin de créer des résultats plus précis. Ceux-ci comprennent les intervalles de confiance, le degré de liberté, la valeur t et le rapport F, entre autres. Comprendre ces concepts et leurs applications permettra à chacun d’évaluer plus efficacement le type de données dont il dispose et de tirer des conclusions appropriées.

Notations statistiques

Les notations statistiques sont essentielles pour comprendre le rôle des paramètres en statistiques. Les variables catégorielles peuvent être représentées par des lettres grecques telles que alpha (α) et bêta (β), tandis que les variables continues (comme les mesures) peuvent être désignées par x. Dans ce contexte, un paramètre est une valeur inconnue utilisée pour représenter les caractéristiques de la population qui doivent être estimées à l’aide de données d’échantillonnage. Par exemple, lors de la représentation de graphes bidimensionnels, le paramètre en statistiques apparaîtra généralement sur la variable de l’axe X, tandis que la variable de l’axe Y représente son estimation de paramètre.

Lors de la détermination des paramètres à partir d’un problème statistique donné, il est important de choisir une notation appropriée afin que les lecteurs comprennent quel type de variable a été sélectionné. Cela aide à éliminer la confusion et à assurer l’exactitude lors de l’interprétation des résultats. En choisissant soigneusement une notation claire et concise pour représenter chaque type de variable – catégorielle ou continue – les chercheurs peuvent communiquer avec précision leurs découvertes sur le rôle des paramètres en statistiques.

Estimation des paramètres

« Une estimation approximative est aussi bonne qu’un échec », ainsi l’estimation des paramètres joue un rôle important en statistiques. Les paramètres peuvent être estimés en mesurant les distributions de fréquence, l’écart-type de l’échantillon et la plage interquartile sur certaines périodes de temps. Par exemple, si le poids corporel d’un groupe de personnes doit être analysé, le poids moyen ou le revenu médian peut servir de paramètre.

La distribution de fréquence indiquera combien d’individus se situent dans chaque intervalle spécifié, tandis que l’écart-type de l’échantillon donne des informations sur la dispersion des points de données autour de la valeur moyenne. La plage interquartile aide à déterminer s’il y a des valeurs aberrantes parmi différents groupes et fournit un aperçu du type de données qui pourrait être attendu lors d’une analyse ultérieure. La combinaison de ces trois mesures peut aider à estimer avec précision les paramètres pour n’importe quel ensemble de données donné.

En comprenant comment utiliser ces techniques pour mesurer et analyser efficacement divers types de données, il est possible d’obtenir des informations significatives à partir d’expériences statistiques et de prendre des décisions plus éclairées.

Méthodes d’estimation de paramètres

Les paramètres jouent un rôle crucial en statistique, tant dans l’estimation des paramètres que dans leur sélection pour les modèles. L’estimation des paramètres est une partie importante de la compréhension des statistiques d’échantillonnage, car elle nous permet d’inférer ce que pourrait être le véritable paramètre de population. Lors de la sélection des paramètres pour notre modèle, nous devons prendre en compte les caractéristiques de base présentes dans nos données d’échantillon telles que la taille et la qualité des ensembles de données. Ce processus nous aide à choisir quelles variables doivent être incluses dans notre modèle.

Il existe plusieurs types courants de méthodes d’estimation de paramètres utilisées lors de la manipulation de statistiques d’échantillonnage. L’estimation du maximum de vraisemblance (MLE) est une méthode populaire utilisée pour estimer les paramètres inconnus dans un modèle statistique basé sur des points de données observés. Un autre type de technique d’estimation de paramètres est l’inférence bayésienne. Cette approche utilise des connaissances et des croyances préalables sur le système étudié pour construire des distributions de probabilité sur les valeurs possibles des paramètres inconnus étant donné les points de données observés. Enfin, une autre technique populaire s’appelle la régression des moindres carrés, qui estime les inconnues en minimisant la somme des carrés des résidus entre les valeurs observées et les valeurs prédites à partir d’une équation ou d’une fonction linéaire.

Ces différentes techniques permettent aux statisticiens d’évaluer avec précision la pertinence de certains paramètres pour leurs modèles et de prendre des décisions éclairées sur ceux qui conduiront à de meilleurs résultats. Ainsi, l’estimation correcte et la sélection de paramètres appropriés peuvent avoir des implications immenses pour le succès ou l’échec de tout projet de modélisation.

Différence entre un paramètre et une statistique

En tant que statisticien, il est important de comprendre la différence entre un paramètre et une statistique. Les paramètres sont des estimations éduquées qui décrivent une population sous-jacente en utilisant des lettres telles que µ (mu) ou σ (sigma). Cela signifie qu’ils ne peuvent être utilisés qu’après que des données ont été collectées auprès de l’ensemble de la population. Les statistiques, en revanche, utilisent des valeurs réelles avec des lettres comme m ou s – ce sont des résultats d’expériences et d’enquêtes effectuées sur des échantillons de populations.

Par exemple, considérez la structure d’erreur binomiale : souvent, les études ont des distributions biaisées où il y a un pourcentage d’études qui montrent des taux beaucoup plus élevés que prévu dans une distribution théorique. Dans ce cas, les paramètres seraient utiles pour décrire l’effet global de l’expérience ; les statistiques fourniront des informations plus spécifiques sur les observations individuelles au sein de chaque groupe d’échantillons.

L’utilisation à la fois de paramètres et de statistiques nous aide à prendre des décisions mieux informées en fonction de notre compréhension de la population dans son ensemble et de la façon dont les individus interagissent les uns avec les autres. En prenant en compte les deux données, nous pouvons créer des modèles précis pour prédire les résultats futurs.

Différence entre les paramètres et les variables

Lorsqu’on pose des questions sur les paramètres en statistiques, il est important de comprendre la différence entre un paramètre et une variable. Les paramètres sont des estimations des caractéristiques de la population qui peuvent être utilisées pour répondre à des questions telles que « Quel est l’âge moyen ? » ou « Combien de personnes vivent dans cette ville ? ». Les variables, quant à elles, sont des choses qui peuvent être mesurées. En ce qui concerne les variables pour les paramètres, il y a deux types : les variables d’échelle – comme la taille, le poids, le revenu – qui mesurent les différences le long d’un intervalle ; et les variables de réponse – comme l’identité de genre, l’affiliation politique – qui mesurent les réponses qualitatives.

En plus de ces types de paramètres et de variables, d’autres paramètres supplémentaires peuvent être mesurés à travers des distributions théoriques pour les ensembles de données plutôt que des distributions réelles. Par exemple, lors de la mesure d’un certain résultat à travers plusieurs échantillons, on peut utiliser une distribution théorique (par exemple, normale) au lieu des valeurs réelles obtenues à partir de chaque groupe d’échantillons. Cela permet aux chercheurs de mieux comparer les résultats entre les groupes et de faire des prédictions plus précises sur les résultats futurs en fonction des mesures actuelles. De plus, parce que les distributions théoriques permettent aux utilisateurs de visualiser des modèles de plus haut niveau dans leurs données, elles fournissent des informations précieuses sur des domaines au-delà de ceux spécifiquement étudiés avec des méthodes traditionnelles.

Dans l’ensemble, comprendre la différence entre les paramètres et les variables est essentiel pour tout chercheur cherchant à analyser des ensembles de données complexes avec précision. En utilisant à la fois des approches empiriques telles que les distributions réelles et des approches théoriques telles que les variables d’échelle ou de réponse, les chercheurs peuvent acquérir une compréhension plus profonde de la façon dont différents facteurs interagissent les uns avec les autres et de la façon dont des changements spécifiques peuvent avoir un impact sur les tendances globales.

Conclusion

Dans un monde axé sur les chiffres, il est souvent difficile de croire que les paramètres et les variables ont quelque chose à voir les uns avec les autres. Après tout, ne sont-ils pas simplement deux faces de la même pièce ? Eh bien, pas tout à fait comme nous venons de le voir !

Les paramètres font référence aux caractéristiques ou attributs qui décrivent une population dans son ensemble. Ils comprennent des choses comme la moyenne, la variance et l’écart-type qui nous fournissent des informations utiles sur l’ensemble de données étudié. Les méthodes d’estimation nous permettent d’estimer ces valeurs à partir d’une taille d’échantillon afin que nous puissions tirer des conclusions sur des populations plus importantes. Il est également important de comprendre la différence entre les paramètres et les statistiques – bien que les deux mesurent certains aspects d’une population, les statistiques utilisent des données d’échantillon tandis que les paramètres utilisent des populations entières à des fins de mesure.

En comprenant les bases des types d’estimations d’intervalles utilisés à des fins de rapport et les avancées des méthodes telles que la base de pourcentage ou les pourcentages de réponses, on peut apprécier à quel point les différents paramètres et variables sont en réalité différents. Savoir quel type d’estimation sert à quelle fin nous donne la capacité de déduire des connaissances sur des systèmes beaucoup plus vastes que nous ne pourrions autrement accomplir seuls. Comme l’a dit Albert Einstein : « Tout doit être rendu aussi simple que possible, mais pas plus simple » – cela s’applique certainement lorsqu’il s’agit de travailler avec des paramètres en statistiques !