Seit der Antike ist Statistik ein Eckpfeiler, um die Welt um uns herum zu verstehen. Von Pythagoras bis zur modernen Datenwissenschaft gibt es ein Element, das von höchster Bedeutung bleibt: Parameter. Parameter sind bei jeder statistischen Analyse wichtig und können den Erfolg eines Experiments ausmachen oder brechen. In diesem Artikel werden wir die Bedeutung von Parametern in der Statistik untersuchen und aufdecken, warum sie für genaue Ergebnisse so wesentlich sind.

Wie jemand einmal sagte, „Eine Reise von tausend Meilen beginnt mit einem einzigen Schritt.“ Um die Rolle von Parametern in der Statistik zu verstehen, hilft es, zuerst ihre Grundlagen zu betrachten: Wie wird statistische Theorie angewendet? Statistik geht im Wesentlichen darum, Muster und Beziehungen zwischen Variablen zu finden; indem man diese Punkte auf einem Graphen darstellt, kann man Schlüsse über Trends und Korrelationen ziehen. Dies wird alles durch die Kombination von zwei Schlüsselideen ermöglicht: Wahrscheinlichkeit und Schlussfolgerung. Die Wahrscheinlichkeit sagt uns, was unter bestimmten Bedingungen wahrscheinlich passieren wird, während die Schlussfolgerung uns ermöglicht, von diesen Beobachtungen zu verallgemeinern und Vorhersagen zu treffen.

Parameter spielen eine wichtige Rolle sowohl in probabilistischen Modellen als auch in inferentiellen Denkprozessen – sie geben Struktur unseren Analysen, indem sie den Bereich der Werte kontrollieren, die zur Berechnung von Wahrscheinlichkeiten und zur Bedeutungsinferenz verwendet werden. Mit einer angemessenen Parameterisierung können Sie präzisere Messungen erhalten, die Einblick in zugrunde liegende Trends innerhalb Ihres Datensatzes geben. Lassen Sie uns also tiefer in das eindringen, was Parameter genau tun, wenn Statistiken analysiert werden – ihre Auswirkungen auf Berechnungen sowie Auswirkungen auf die Genauigkeit -, damit auch Sie die Kraft von Parametern in Ihrer eigenen Forschung freisetzen können!

Was sind Parameter?

Es ist fast ironisch, dass bei der Betrachtung von Parametern in der Statistik die erste Frage lautet: „Was sind Parameter?“. Parameter werden seit langem verwendet, um Bevölkerungsmerkmale darzustellen und zu messen. Tatsächlich sind sie so wichtig für die Inferenzstatistik geworden, dass ihre Bedeutung nicht überschätzt werden kann.

Parameter ermöglichen es uns, Stichproben mit Populationen zu vergleichen, indem wir bestimmte Merkmale der Stichprobengröße oder sogar der gesamten Datensätze bewerten. Sie helfen uns festzustellen, ob die gegebene Stichprobe einer Normalverteilung folgt und ihre zentrale Tendenz mithilfe von Maßen wie Mittelwert und Varianz zu identifizieren. Dies hilft uns auch zu beurteilen, wie viel Variation zwischen zufälligen Stichproben aus derselben Population besteht – etwas, das wir Standardabweichung nennen, die normalerweise durch die Quadratwurzel der Varianz gemessen wird.

Zusammenfassend spielen Parameter eine wichtige Rolle in der Inferenzstatistik, da sie Einblicke in Bevölkerungsmerkmale durch den Vergleich verschiedener Stichproben liefern. Ohne sie wäre es unmöglich, gültige Annahmen über unsere Datensätze zu treffen und genaue Schlussfolgerungen über die zugrunde liegende Population zu ziehen.

Arten von Parametern

Die verschiedenen Arten von Parametern zu kennen und zu verstehen, wie sie verwendet werden, kann wie das Entdecken eines verborgenen Schatzes sein – es eröffnet eine völlig neue Welt des Verständnisses und der Erkenntnis. In der Statistik gibt es zwei Hauptarten von Parametern: deskriptive Statistiken und gemeinsame Parameter.

Deskriptive Statistiken helfen dabei, einen Datensatz durch die Bereitstellung numerischer Merkmale wie Bereich und Mittelwert zusammenzufassen. Gemeinsame Parameter stammen aus Wahrscheinlichkeitsverteilungen, die die Wahrscheinlichkeit bestimmter Ergebnisse bei der Stichprobenfehleranalyse beschreiben. Sie geben uns Einblicke in zukünftige Trends, indem sie vergangene Daten betrachten. Statistische Inferenz hilft uns, Schlussfolgerungen über Populationen zu ziehen, basierend auf dem, was wir aus Stichproben-Datensätzen lernen.

Der Wertebereich, der mit jeder Art von Parameter verbunden ist, ist bei der Datenanalyse wichtig, da er uns eine gute Vorstellung davon gibt, wie viel Variation innerhalb der Stichprobenpopulation oder zwischen verschiedenen Stichproben existiert. Durch Betrachtung sowohl deskriptiver Statistiken als auch gemeinsamer Parameter können wir wertvolle Informationen über unsere Datensätze gewinnen, damit wir informierte Entscheidungen für die Zukunft treffen können.

Beispiele für Parameter in der Statistik

Manche mögen argumentieren, dass Beispiele für Parameter in der Statistik zu abstrakt sind, um sie zu verstehen. Im Gegenteil, das Verständnis dafür, wie und warum Parameter existieren, ist für jede statistische Analyse unerlässlich.

Parameter wie die Größe der Population dienen als Grundlage für alle statistischen Berechnungen. Wenn Sie beispielsweise eine unvoreingenommene Schätzung aus einer zufälligen Stichprobe generieren möchten, muss die Größe der Population bekannt sein, damit sie die binomiale Verteilung und die Stichprobenvarianz beeinflussen kann. Ebenso ist es wichtig, bei der Bestimmung des Standardfehlers einer repräsentativen Stichprobe Kenntnisse über Parameter wie die Größe der Population zu haben. Durch die Fähigkeit, diese Parameter und ihren Zweck in der Statistik zu identifizieren, kann man tiefere Einblicke gewinnen, wie man Daten korrekt interpretiert.

Zusätzlich dazu existieren auch andere Arten von Parametern, die sich gegenseitig ergänzen, um genauere Ergebnisse zu erzielen. Dazu gehören unter anderem Konfidenzintervalle, Freiheitsgrade, t-Werte und F-Verhältnisse. Das Verständnis dieser Konzepte und ihrer Anwendungen ermöglicht es, besser zu beurteilen, welche Art von Daten zur Verfügung steht und angemessene Schlussfolgerungen daraus zu ziehen.

Statistische Notationen

Statistische Notationen sind unerlässlich, um die Rolle von Parametern in der Statistik zu verstehen. Kategoriale Variablen können mit griechischen Buchstaben wie Alpha (α) und Beta (β) dargestellt werden, während kontinuierliche Variablen (wie Messungen) durch x bezeichnet werden können. In diesem Kontext ist ein Parameter ein unbekannter Wert, der verwendet wird, um Populationseigenschaften darzustellen, die mit Hilfe von Stichproben geschätzt werden müssen. Wenn beispielsweise zweidimensionale Grafiken gezeichnet werden, wird der Parameter in der Statistik in der Regel auf der X-Achsenvariable erscheinen, während die Y-Achsenvariable seine Parameterabschätzung darstellt.

Bei der Bestimmung von Parametern aus einem gegebenen statistischen Problem ist es wichtig, eine geeignete Notation zu wählen, damit die Leser verstehen, welche Art von Variable ausgewählt wurde. Dies hilft, Verwirrung zu beseitigen und die Genauigkeit bei der Interpretation von Ergebnissen zu gewährleisten. Durch sorgfältige Auswahl einer klaren und prägnanten Notation zur Darstellung jeder Art von Variable – kategorial oder kontinuierlich – können Forscher ihre Ergebnisse über die Rolle von Parametern in der Statistik genau kommunizieren.

Schätzung von Parametern

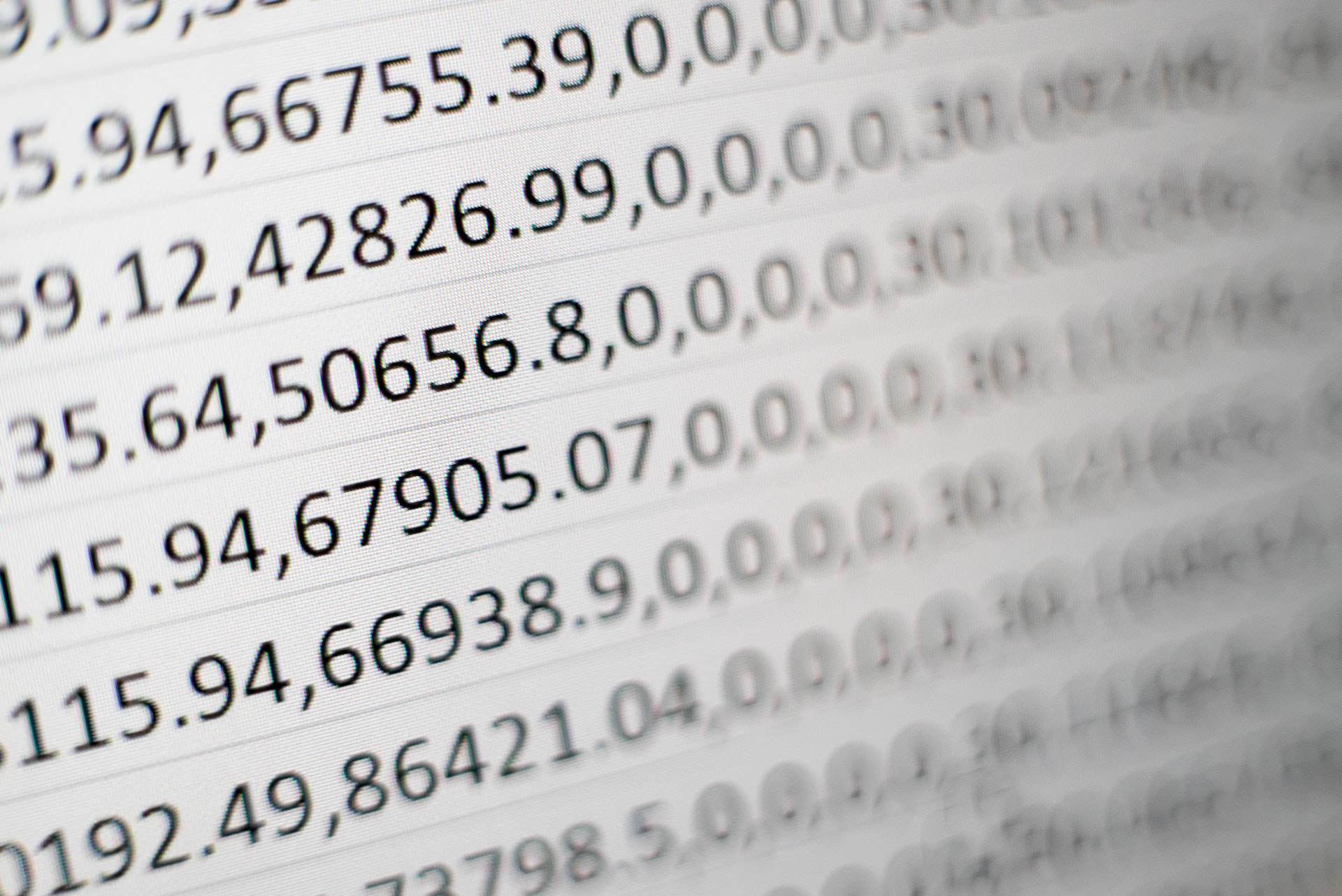

„Ein Schuss ins Blaue ist genauso gut wie ein Fehlschuss“, daher spielt die Schätzung von Parametern eine wichtige Rolle in der Statistik. Parameter können durch Messung von Häufigkeitsverteilungen, Stichprobenstandardabweichung und Interquartilsabstand über bestimmte Zeitperioden geschätzt werden. Wenn beispielsweise das Körpergewicht einer Gruppe von Menschen analysiert werden soll, kann das durchschnittliche Gewicht oder das Median-Einkommen als Parameter dienen.

Die Häufigkeitsverteilung gibt an, wie viele Personen innerhalb jedes bestimmten Intervalls fallen, während die Stichprobenstandardabweichung Informationen über die Streuung der Datenpunkte um den Mittelwert liefert. Der Interquartilsabstand hilft dabei, festzustellen, ob es Ausreißer zwischen verschiedenen Gruppen gibt, und gibt Einblick darüber, welche Art von Daten bei weiteren Analysen erwartet werden kann. Die Kombination dieser drei Messungen kann dazu beitragen, Parameter für jeden gegebenen Datensatz genau zu schätzen.

Durch das Verständnis, wie man diese Techniken effektiv zur Messung und Analyse verschiedener Arten von Daten einsetzt, ist es möglich, sinnvolle Erkenntnisse aus statistischen Experimenten zu gewinnen und informiertere Entscheidungen zu treffen.

Methoden zur Parameterschätzung

Parameter spielen in der Statistik eine entscheidende Rolle, sowohl bei der Schätzung von Parametern als auch bei ihrer Auswahl für Modelle. Die Schätzung von Parametern ist ein wichtiger Teil des Verständnisses von Stichprobenstatistiken, da sie es uns ermöglicht, zu schlussfolgern, was der wahre Populationsparameter sein könnte. Bei der Auswahl von Parametern für unser Modell müssen wir die Grundmerkmale berücksichtigen, die in unseren Stichprobendaten vorhanden sind, wie Größe und Qualität der Datensätze. Dieser Prozess hilft uns bei der Auswahl, welche Variablen in unser Modell aufgenommen werden sollten.

Es gibt mehrere gängige Arten von Methoden zur Parameterschätzung, die bei der Arbeit mit Stichprobenstatistiken verwendet werden. Maximum-Likelihood-Schätzung (MLE) ist eine beliebte Methode zur Schätzung unbekannter Parameter in einem statistischen Modell auf der Grundlage beobachteter Datenpunkte. Eine andere Art von Parameterschätztechnik ist Bayesianische Inferenz. Dieser Ansatz verwendet Vorwissen und Überzeugungen über das untersuchte System, um Wahrscheinlichkeitsverteilungen über mögliche Werte unbekannter Parameter auf der Grundlage der beobachteten Datenpunkte zu erstellen. Schließlich gibt es noch eine beliebte Technik namens Least-Squares-Regression, die Unbekannte schätzt, indem sie die Summe der quadrierten Residuen zwischen beobachteten Werten und vorhergesagten Werten aus einer linearen Gleichung oder Funktion minimiert.

Diese verschiedenen Techniken ermöglichen es Statistikern, genau zu beurteilen, wie gut bestimmte Parameter in ihre Modelle passen, und informierte Entscheidungen darüber zu treffen, welche zu besseren Ergebnissen führen werden. Daher kann die ordnungsgemäße Schätzung und Auswahl geeigneter Parameter immense Auswirkungen auf den Erfolg oder Misserfolg jedes Modellierungsprojekts haben.

Unterschied zwischen einem Parameter und einer Statistik

Als Statistiker ist es wichtig, den Unterschied zwischen einem Parameter und einer Statistik zu verstehen. Parameter sind gebildete Vermutungen, die eine zugrunde liegende Population mit Buchstaben wie µ (mu) oder σ (sigma) beschreiben. Das bedeutet, dass sie nur verwendet werden können, nachdem Daten von der gesamten Population gesammelt wurden. Statistiken hingegen verwenden tatsächliche Werte mit Buchstaben wie m oder s – diese sind Ergebnisse von Experimenten und Umfragen, die aus Stichproben von Populationen genommen wurden.

Beispielsweise betrachten Sie die binomiale Fehlerstruktur: Oft haben Studien verzerrte Verteilungen, bei denen ein Prozentsatz von Studien viel höhere Raten als erwartet in einer theoretischen Verteilung aufweist. In diesem Fall wären Parameter nützlich, um den Gesamteffekt des Experiments zu beschreiben; Statistiken liefern spezifischere Informationen über einzelne Beobachtungen innerhalb jeder Stichprobengruppe.

Die Verwendung von Parametern und Statistiken hilft uns, bessere Entscheidungen zu treffen, die auf unserem Verständnis der Gesamtpopulation und der Interaktionen zwischen Individuen basieren. Indem wir beide Datensätze berücksichtigen, können wir genaue Modelle zur Vorhersage zukünftiger Ergebnisse erstellen.

Unterschied zwischen Parametern und Variablen

Wenn es um Fragen zu Parametern in der Statistik geht, ist es wichtig, den Unterschied zwischen einem Parameter und einer Variable zu verstehen. Parameter sind Schätzungen von Merkmalen der Population, die verwendet werden können, um Fragen wie „Was ist das durchschnittliche Alter?“ oder „Wie viele Menschen leben in dieser Stadt?“ zu beantworten. Variablen hingegen sind Dinge, die gemessen werden können. In Bezug auf Variablen für Parameter gibt es zwei Arten: Skalenvariablen – wie Größe, Gewicht, Einkommen – die Unterschiede entlang eines Intervalls messen; und Antwortvariablen – wie Geschlechtsidentität, politische Zugehörigkeit – die qualitative Antworten messen.

Neben diesen Arten von Parametern und Variablen können auch weitere zusätzliche Parameter durch theoretische Verteilungen für Datensätze gemessen werden, anstatt durch wahre Verteilungen. Wenn beispielsweise ein bestimmtes Ergebnis über mehrere Stichproben gemessen wird, kann man eine theoretische Verteilung (z.B. normal) anstelle der tatsächlichen Werte aus jeder Stichprobengruppe verwenden. Dies ermöglicht es Forschern, Ergebnisse besser über Gruppen hinweg zu vergleichen und genauere Vorhersagen über zukünftige Ergebnisse auf der Grundlage aktueller Messungen zu treffen. Darüber hinaus ermöglichen theoretische Verteilungen Benutzern, höhere Muster in ihren Daten zu sehen, was wertvolle Einblicke in Bereiche jenseits der mit traditionellen Methoden speziell untersuchten Bereiche bietet.

Insgesamt ist das Verständnis des Unterschieds zwischen Parametern und Variablen für jeden Forscher, der komplexe Datensätze genau analysieren möchte, unerlässlich. Durch die Verwendung von sowohl empirischen Ansätzen wie wahren Verteilungen als auch theoretischen Ansätzen wie Skalen- oder Antwortvariablen können Forscher tiefere Einblicke gewinnen, wie verschiedene Faktoren miteinander interagieren und wie spezifische Veränderungen den Gesamttrends beeinflussen können.

Abschluss

In einer von Zahlen getriebenen Welt fällt es oft schwer zu glauben, dass Parameter und Variablen miteinander zu tun haben. Schließlich sind sie doch nur zwei Seiten derselben Medaille? Nun, nicht ganz, wie wir gerade gesehen haben!

Parameter beziehen sich auf Merkmale oder Attribute, die eine Population als Ganzes beschreiben. Dazu gehören Dinge wie Mittelwert, Varianz und Standardabweichung, die uns nützliche Informationen über den untersuchten Datensatz liefern. Schätzmethoden ermöglichen es uns, diese Werte aus einer Stichprobengröße zu schätzen, damit wir Schlüsse über größere Populationen ziehen können. Es ist auch wichtig, den Unterschied zwischen Parametern und Statistiken zu verstehen – während beide bestimmte Aspekte einer Population messen, verwenden Statistiken Stichproben-Daten, während Parameter gesamte Populationen für Messzwecke verwenden.

Durch das Verständnis der Grundlagen der Arten von Intervallschätzungen, die für Berichtszwecke verwendet werden, und Fortschritten bei Methoden wie Prozentbasis oder Prozentsätzen von Antworten kann man schätzen lernen, wie unterschiedlich Parameter und Variablen tatsächlich sind. Zu wissen, welche Art von Schätzung welchem Zweck dient, gibt uns die Fähigkeit, Wissen über viel größere Systeme zu inferieren, als wir es sonst alleine erreichen könnten. Wie Albert Einstein einmal sagte: „Alles sollte so einfach wie möglich gemacht werden, aber nicht einfacher“ – dies gilt sicherlich, wenn es um die Arbeit mit Parametern in der Statistik geht!